DX推進チームがお届けする、業務改善レポートです。以前のレポートで、私たちはクラウドAIを活用した音声アシスタント開発の成功と、その先で見えた本質的な課題について報告しました。

今回のレポートは、その続編です。前回の実験で見えた課題への明確な答えとして、私たちが最終的にたどり着いた「完全ローカルRAGアシスタント」について。その構築の動機から全貌、そして未来の展望までを詳細にレポートします。

構築の動機:クラウドの先に見えた「3つの必然」

前回のクラウドAIエージェント開発は、AIが業務タスクを自動化する可能性を証明しました。しかし同時に、この強力な技術を全社的に展開するには、乗り越えるべき3つの大きな壁があることも明らかになりました。

- セキュリティの壁: 企業の生命線である機密情報や顧客データを、外部のサーバーと通信させるわけにはいかない。これは、ビジネスにおける絶対的な要件でした。

- ナレッジの壁: 本当に賢いアシスタントを作るには、社内に散在するPDFやWord、テキストファイルといった膨大な知識資産を一元的に集約し、AIの「記憶」とする必要がありました。

- コストの壁: クラウドAIのAPIは非常に強力ですが、利用量に応じてコストが増加します。全社員が気兼ねなく使える環境を考えると、ランニングコストは無視できない問題でした。

これらの課題をすべて解決する唯一の方法、それは「自分たちのデータを、自分たちの管理下で、コストを気にせず使えるAI」を自ら構築することでした。

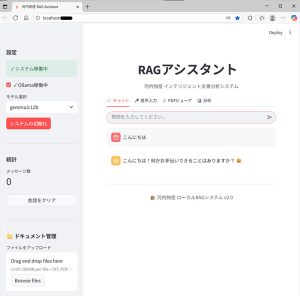

わずか数日でプロトタイプ完成:「インテリジェント文書分析システム」

驚くことに、このシステムの基本構築にかかった期間は、わずか数日程度でした。これは、Ollama、LangChain、Streamlitといった強力なオープンソースツールのエコシステムがいかに成熟しているかを物語っています。

このアシスタントは、Googleの高性能オープンソースモデル「Gemma 3」を心臓部に、完全にローカルPC上で動作します。これにより、前述の3つの壁を以下のように乗り越え、多彩な機能を実現しました。

- 多彩なインターフェース: シンプルなチャット形式での対話はもちろん、マイクを使った音声入力にも対応しています。

- 多様なド-キュメント対応: PDFやテキストファイルなど、社内に存在する様々な形式のドキュメントをドラッグ&ドロップで簡単に知識ベース化できます。

- 完全なセキュリティ: データがPCから一切出ないため、プライバシーと機密情報を完全に保護します。

- 圧倒的なコストパフォーマンス: API利用料はゼロ。オープンソースの組み合わせにより、ランニングコストを気にせず利用できます。

今回のテスト構築で採用した技術は、決して最先端のものではありません。しかし、成熟したオープンソース技術を組み合わせることで、私たちが抱える「セキュリティ」「ナレッジ」「コスト」という3つの課題に対して、これ以上ないほどの「最適解」を導き出すことができました。

システムの仕組み:AIが社内文書を「読む」まで

このシステムの裏側を、専門用語を避けて簡単に説明します。

- まず、社内にあるPDFやテキストファイルなどのドキュメントを、AIアシスタントに「知識」としてアップロードします。

- アシスタントは、その文書を後で探しやすいように、内容を整理して専用のデータベースに保管します。

- ユーザーが質問をすると、アシスタントはまずデータベースの中から関連する情報を探し出します。

- 最後に、その見つけ出した情報だけを根拠にして、AIが自然な文章で回答を生成します。

このシンプルな仕組みにより、AIはまるで社内文書をすべて読んだかのように、正確な回答を返すことができるのです。

安心感を支える3つの工夫

私たちは、このシステムを誰もが安心して使えるように、いくつかの工夫を凝らしました。

- 丁寧なエラー対応: ファイルが空だったり、答えが見つからなかったりした場合でも、システムが停止せず、状況を優しく教えてくれます。

- 賢いキャッシュ機能: 同じ質問には、AIを毎回動かさずに保存しておいた答えを返すことで、高速な応答を実現しています。

- 「根拠」の見える化: AIの回答が「どの文書のどの部分に基づいているか」を常に表示します。これにより、ユーザーはいつでも元の資料を確認でき、AIの答えを鵜呑みにする心配がありません。

次なる一手:ローカルとクラウドの「ハイブリッド化」へ

このローカルRAGアシスタントは、社内情報を扱う「守りのAI」として、完璧な基盤となりました。しかし、私たちの挑戦はここで終わりません。

次なるステップは、このローカルAIと、創造性や外部情報へのアクセスに優れたクラウドLLMを連携させる「ハイブリッド構成」の実現です。

- 社内の機密情報に関する質問 → ローカルRAGが担当

- 新しい企画のアイデア出しや、市場調査 → クラウドLLMが担当

ユーザーからの質問の意図をAI自身が判断し、最適なAIに自動でタスクを振り分ける。この仕組みが完成した時、私たちのAIアシスタントは、セキュリティと無限の可能性を両立した、真の「第二の脳」へと進化を遂げるでしょう。なお、本システムはすべての業務をAIに任せるものではなく、人の判断を支援するための「知識基盤」として位置づけています。

最終的な判断と責任は、常に人が担います。

この記事が、皆さんの会社の業務改善、そしてAI活用のヒントになれば幸いです。