DX推進チームがお届けする、業務改善レポートです。 今回は、数ヶ月にわたって取り組んできた「スマホで使える音声AIアシスタント」の自社開発実験プロジェクトについて、その過程をレポートします。

始まりは「声で在庫確認できたら最高だ!」

「品番XXの在庫は?」 この日常的な質問に、PCや管理画面を操作することなく、アシスタントに話しかけるようにして答えが返ってくる。これを実現するため、私たちはVertex AIなどでなるべくランニングコストが発生しない、社内のためのAIエージェント開発に着手しました。

技術の裏側:AIアシスタントを構成する要素たち

このAIアシスタントは、役割の異なる様々な技術を組み合わせることで成り立っています。

- 頭脳 (LLM):Vertex AI

AIエージェント全体の司令塔です。ユーザーからの質問の意図を理解し、どのツールを使って情報を集めるべきかを判断し、最終的な回答を自然な文章で生成する、最も重要な「頭脳」の役割を担います。

- 手足 (カスタムツール)

LLMの指示を受けて実際に作業を行う「手足」です。今回は2種類のツールを自社開発しました。

- 楽天在庫調査ツール: 楽天APIと連携し、品番からリアルタイムの在庫数を取得します。

- 社内製品情報ツール: 社内の製品データベースと連携し、商品名やスペックを検索します。

- 耳 (音声入力):Speech-to-Text API

ユーザーがスマホのマイクに向かって話した声を、AIが理解できるテキストデータに変換する「耳」の役割です。このAPIのおかげで、非常に高精度な音声認識が可能になります。

- 口 (音声応答):Text-to-Speech API

AIが生成したテキストの回答を、人間らしい自然な音声に変換する「口」の役割を担います。これにより、ユーザーは画面を見ずに耳で回答を聞くことができます。

- 体 (UI):Streamlitフレームワーク

これらの機能を一つにまとめ、ユーザーがスマートフォンで直感的に操作できるインターフェース(UI)を提供するのが、Streamlitです。 Web開発の専門知識がなくても、Webアプリを驚くほど簡単に作れる魔法のようなツールです。マイクの録音ボタンやチャット履歴の表示といった画面を短時間で構築し、社員がスマホのブラウザから手軽にアクセスできる環境を実現しました。

プロトタイプの完成、そして進化へ

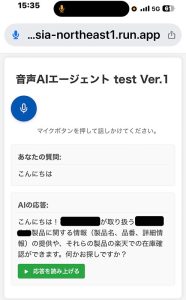

これらの技術を組み合わせ、完成したのがこの初期プロトタイプです。

(画像は、音声AIエージェントの初期UI。「こんにちは」という挨拶に、AIが自己紹介で応答している様子)

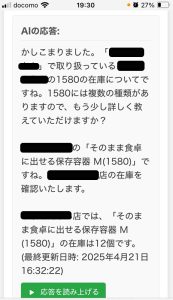

そして、私たちはAIエージェントをさらに進化させ、単なる一問一答だけでなく、曖昧な質問をAI自身が解決する「本当の対話」の実現を目指しました。その結果が、このやり取りです。

AIの応答:

かしこまりました。「○○○○」で取り扱っている○○〇〇の1580の在庫についてですね。1580には複数の種類がありますので、もう少し詳しく教えていただけますか?(ユーザーがMサイズを指定)

○○○○の「そのまま食卓に出せる保存容器 M(1580)」ですね。○○○○店の在庫を確認いたします。

○○○○店では、「そのまま食卓に出せる保存容器 M(1580)」の在庫は12個です。

このやり取りは、AIが自ら情報の不足に気づき、ユーザーに追加情報を求め、得られた答えを元に次のアクションを実行するという、高度な「対話」が実現できた瞬間でした。

技術的には成功を収めたこのプロジェクト。しかし、この成功の先で、私たちはAIをビジネスに本格導入するための、より本質的な課題と向き合うことになります。なお、これらの仕組みはあくまで人の判断を支援するためのものであり、最終判断や責任は常に人が担います。